In diesem Blogbeitrag möchten wir uns mit den möglichen Tools beschäftigen, die für Data Science zum Einsatz kommen. Wir bei OpenAdvice (mittlerweile Teil der TIMETOACT) bevorzugen den Einsatz von Jupyter Notebooks in Kombination mit einer Python Version. Welche Vorteile solche Notebooks haben und wie sie mit ihnen arbeiten können, werden wir in diesem Beitrag aufzeigen.

Über Jupyter Notebooks

Jupyter (eine Mischung aus den drei Programmiersprachen Julia, Python & R) ist ein Open Source Projekt, um das Arbeiten mit diversen Programmiersprachen in einer Umgebung möglichst simpel und anschaulich zu gestalten. Ein riesiger Vorteil ist die Darstellung. Wo andere GUIs (graphische Benutzeroberflächen) viele Möglichkeiten, insbesondere Debugger, liefern und oft erschlagend umfangreich sind, glänzt Jupyter mit Übersichtlichkeit ohne Abstriche in der Funktionalität. Den Grundstock bilden sogenannte Zellen. Hier gibt es die Möglichkeit zwischen Code-Zellen (zum Programmieren) und Markdown-Zellen zu wählen. Man kann dementsprechend seinen Code mit Texten, Bildern und z.B. auch .gif Datein kombinieren. Erzeugte Plots, Karten oder Grafiken werden ebenfalls direkt im Notebook dargestellt. Das leichte Exportieren in verschiedene Formate (.pdf, .html, .py, .tex,…) kreiert so ein vollständiges Dokument. So ist es möglich seine Erkenntnisse direkt auszuformulieren und mit dem Code und Grafiken zusammen zu einer Analyse im PDF Format zu exportieren. Alle Beitrage aus dieser Reihe sind und werden aus demonstrationszwecken ebenfalls ausschließlich mit Jupyter Notebooks erstellt. Gerade im Bereich Data Science, wo es u.a. darum geht mit Daten zu jonglieren, sie zu untersuchen, zu visualisieren und die daraus gezogenen Kenntnisse auszuformulieren, liefern Jupyter Notebooks die perfekte Basis alle Aufgabe mit einem (kostenlosen) Tool zu bewältigen. Die einzelnen Stationen eines typischen Projekts wollen wir kurz anschneiden und erklären.

ETL - Extract Transform Load

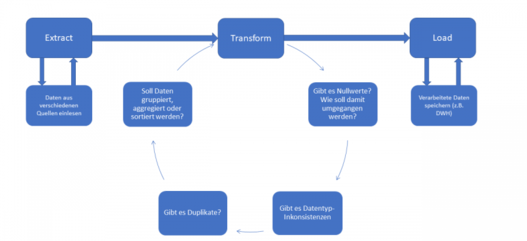

Nachdem man sich mit der Materie des Projekt vertraut gemacht hat, ist es essenziell die zugehörigen Daten zu sammeln, diese aufzubereiten und anschließend zur Weiterverarbeitung zu sichern. Dieses Vorgehen nennt man auch ETL-Prozess.

Ein typischer ETL Prozess könnte so aussehen:

Einlesen von Daten

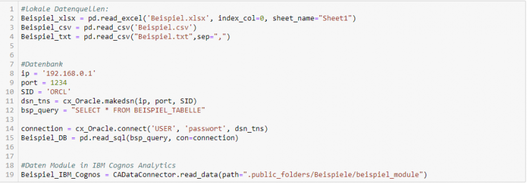

Wir wollen einige Möglichkeiten präsentieren, wie man verschiedene Datenquellen mit Python einlesen kann. Zur Datensicherung und -aufbereitung bietet sich das Package Pandas an. Damit werden eingelesene Daten in DataFrames (Tabellen) gespeichert. Ein mal eingelesen kann man diese beliebig weiterverarbeiten. Das macht das Aufbereiten sehr viel handlicher. Neben der Möglichkeit lokal mit Jupyter Notebooks zu arbeiten, gibt es auch in IBM Cognos Analytics die Möglichkeit mit Notebooks zu arbeiten. Die in IBM Cognos Analytics erstellen Datenmodule, Data Sources und auch hochgeladenen Datein können leicht eingelesen werden. Hierfür gibt es einen integrierten Data Connector (CADataConnector). Auch diese eingelesenen Daten werden in einem DataFrame gespeichert.

Datenverarbeitung

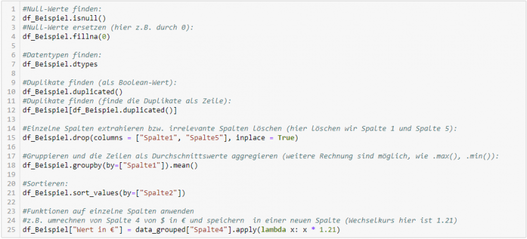

Nachdem wir nun Daten eingelesen haben, können wir mit ihnen arbeiten, sie aufbereiten und auch damit rechnen. Die Pandas library bietet hierfür eine Vielzahl von Möglichkeiten. Wie man Daten in ein Notebook einliest haben wir bereits gesehen. Einige der oben aufgeführten Transformationen wollen wir ihnen vorführen. Viele dieser Verarbeitungsschritte sind sogenannte One-liner, das heißt, sie können in nur einer Zeile Code umgesetzt werden. Wir wollen annehmen, dass wir unsere Daten in einem DataFrame namens “df_Beispiel” eingelesen haben.

Datensicherung

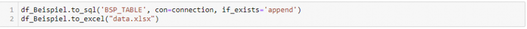

Je nach Anforderung können die Daten direkt in eine Datenbank geschrieben werden, oder lokal in Form einer Datei gesichert werden.

Natürlich ist ein ETL Prozess weitaus komplexer und umfangreicher und je nach Projektziel müssen auch weitere Transformationen passieren. Mit diesem Beitrag sollten sie einen kurzen Einblick erhalten wie ein ETL Prozess aussehen könnte. Im nächsten Beitrag dieser Serie freuen wir uns, ihnen verschiedene Arten von Visualisierungen zu zeigen, um die bearbeiteten Daten zielgerecht präsentieren zu können.

Erfahren Sie mehr

IBM Watson Studio

Tipps & Tools für eine erfolgreiche interne Kommunikation

IBM SPSS Modeler

Data Science, Artificial Intelligence und Machine Learning

X-INTEGRATE erweitert Partnerschaft mit Talend

Datengetriebene Prozesse & Geschäftsmodelle

Microsoft Azure

Zero Trust – oder lassen Sie jeden rein?

IBM Cloud Pak for Data

SQL Server als Datenbankmanagementsystem

ESG-Tagebuch | Implementierung von Envizi ESG Suite |Teil 1

Miltenyi Biotec: Azure und Xamarin optimieren Prozesse

Aqeel Alazree

Microsoft Viva – was bietet die neue Plattform?

IBM Cloud Pak for Data – Test-Drive

Wie IBM FileNet und WatsonX.AI den Arbeitsalltag verändern

IBM Decision Optimization

Managed Service: Prozesse optimieren & Sicherheit erhöhen

Microsoft Fabric: Zentrale Data- und Analytics-Plattform

GreenOps: Der Weg zu Transparenz und Effizienz in der Cloud

Angular 5 Custom Filter in Angular Material Data-Table

TIMETOACT GROUP auf dem Data & AI Forum 2020

CSRD mit grüner Technologie umsetzen

Data Integration Service und Consulting für Ihr Unternehmen

Talend Data Integration

Chromebooks holen auf

Schaffung einer modernen Datenplattform

vdek führt neue Data-Warehouse-Lösung ein

Geschäftsoptimierung mit mathematische Berechnungen

Passwort oder Iris-Scan: Die Zukunft der Authentisierung

Beratung rund um IBM watsonx.ai

IAM-Prozesse – Betrachtungswinkel und Prozesssichtweisen

Mit Nachhaltigkeit zu mehr Bewusstsein und Verantwortung

Datengetriebene Prozesse & Geschäftsmodelle

Data Vault als Modellierungsansatz von Data Warehouse

Einlesen großer Dateien mit Camel

ESG-Tagebuch | Nachhaltige Datenlösungen realisieren |Teil 3

Prozess Management

Prozess Automatisierung

Eventserie: Einfach, Schnell, Erfolgreich mit Mendix

Data Lake vs Data Warehouse: Welche Lösung ist die Richtige?

Digitalisierte Prozesse steigern Effizienz

Individuelle Java-Anpassungen in Optimierungsprojekten

Artificial Intelligence (AI) mit Spurhalteassistent im Griff

Das erwartet Sie beim Software Compliance Audit

Ein Public Cloud Cheat Sheet der führenden Cloud Provider

Automatisierter Testing Prozess mit Power Apps

HCL

Vorteile und Umsetzung eines Single-Point-of-Truths

Standardisiertes Datenmanagement bei TRUMPF

Data Science, AI & Advanced Analytics

ESG-Tagebuch | Wissenstransfer & Kommunikation | Teil 2

Enterprise Observability mit IBM Instana

Data Fabric: Basis für Analytics und KI der nächsten Stufe

Datenmanagement und Datenintegration in der Praxis

Zentrales Capacity Management bei Sunrise

KI Governance

Information Architecture Digital Partner Summit EMEA

Digitalisierung und Optimierung in der Fertigungsindustrie

Spaltenformatierung in SharePoint: Column formatting vs. JS

VYSYO – Zeit- & Kostenersparnisse dank neuester Technologien

Lizenzmanagement fest im Griff - Das sollten Sie wissen!

Wer benötigt ein Intranet?

Working @ novaCapta: Cristinas Insights

Graphentechnologie

Talend Data Fabric

"AI eats (IT) startegy for breakfast" Eventreihe

Kleine Einführung ins Thema Softwarelizenzen

Cloud-Strategie nach der Pandemie

Roadmap zu digitalen Produkten

PIM- oder ERP-first?

Routenplanung mit IBM ILOG Transportation Analyst

Jira Administration Part 2 (Data Center)

Beratung rund um IBM watsonx.data

Fachbeitrag: Dem Chatbot das Halluzinieren austreiben

Releasewechsel eines eingesetzten IAM-Tools

Migration von HCL Domino/Notes zu Microsoft 365

AWS Cloud: So optimieren Sie Ihre Kosten mit IBM Turbonomic!

Frequently Asked Questions novaCapta Schweiz

IT Service Management Beratung: Prozesse mit IT unterstützen

IT Asset Management: Mit Program Design Prozesse optimieren

Modernisierung der Contact-Center-Prozesse

FIVE: Prozess-Automation auch für KMUs

Digitalisierte Prozesse steigern Effizienz

Beratung rund um Mendix

SQL Server

Dashboards & Reports zur Visualisierung von Informationen

Mehr Transparenz mit AI Governance

Open Source

Cybersecurity Evolution: NIS-2

IT: Schlüssel zum erfolgreichen Nachhaltigkeitsmanagement?!

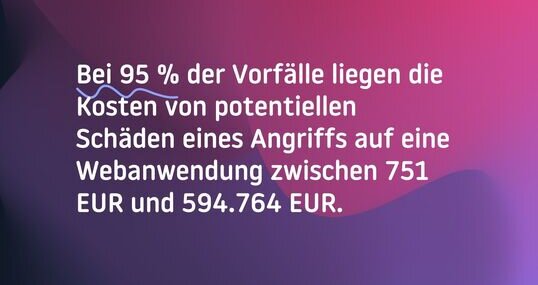

Die Notwendigkeit einer Web Application Firewall im Internet

Beratung rund um IBM Watsonx BI Assistant

DORA: Stärkung der Resilienz im europäischen Finanzwesen

Highlights & Eindrücke: Nachbericht zur Atlassian Team'23

Digitale Sichtbarkeit: Ein MUSS für den Erfolg

D2C-Potentiale für mehr Wiederholungskäufer ausschöpfen

Google Analytics

Stay productive, stay safe - unsere Homeoffice Tipps für Sie